a16z 对话 Poe 创始人:大模型幻觉是创业公司的机会;AI 的未来是多模型、多模态

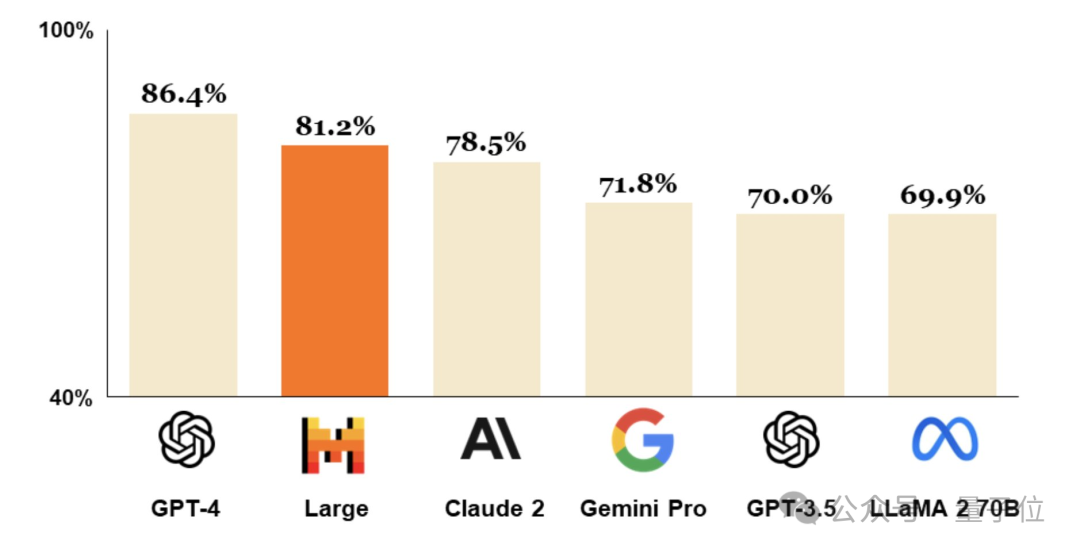

a16z 对话 Poe 创始人:大模型幻觉是创业公司的机会;AI 的未来是多模型、多模态作为 Meta 的前 CTO,Quora CEO Adam D'Angelo 目前还是 OpenAI 的董事会成员,在 Quora 之外推出的 Poe,成为当下接入大模型最多的 Chatbot 平台:GPT-4、Claude3、Mistral 等模型都有,用户也可以在上面搭建自己的 Chatbot 机器人,如果有别的用户使用,还可以产生收益。